Apple anunció nuevas características en iCloud y iMessage con el fin de “proteger la infancia”, lo que en el fondo es un paso que erosiona los sistemas criptográficos que defienden la privacidad de nuestros datos y comunicaciones. Este tipo de funcionalidad ha sido pedida muy ansiosamente por gobiernos y autoridades en todo el mundo. La necesaria y urgente lucha contra los crímenes contra la infancia está en el eje de esta discusión pero sus efectos van mucho más allá.

Aunque Apple trate de amortiguar su anuncio diciendo que estas nuevas medidas son compatibles con la privacidad porque funcionan del lado del cliente (es decir, en el propio dispositivo de las personas y no en los servidores de la compañía) y que se limita a un tipo específico de datos (en este caso imágenes que puedan afectar la integridad de menores de edad), el problema es la dificultad para garantizar y mantener esos límites. Un sistema así puede ser fácilmente abusado por la misma compañía o peor aún, por un gobierno autoritario para buscar otro tipo de datos dentro de dispositivos altamente sensibles, que revelan por ejemplo a fuentes de periodistas, inclinaciones sexuales o preferencias políticas.

Para desenredar este nuevo capítulo de las crypto wars hay que entender qué hacen los nuevos sistemas de vigilancia de Apple y las motivaciones para implementarlos (que sobrepasan la protección de la infancia).

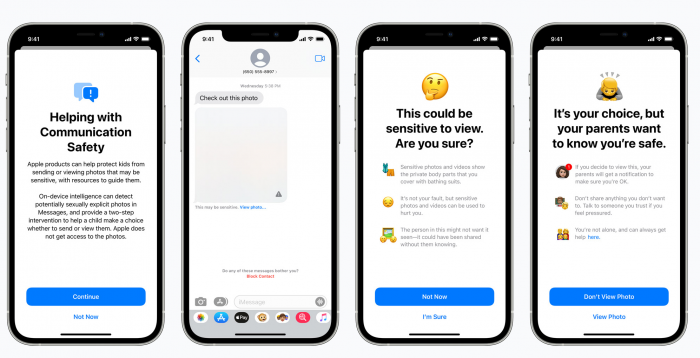

Por un lado, Apple implementará una nueva característica de control parental en dispositivos a nombre de niños y niñas, que escaneará con inteligencia artificial todas las imágenes enviadas y recibidas con iMessage para determinar si son contenido sexual, alertando a los padres, si el menor las ve o las envía.

iMessage, como WhatsApp o Signal, es una aplicación de mensajería instantánea que usa cifrado de extremo a extremo, lo cual garantiza que los mensajes y las llamadas que se hacen por esta aplicación no puedan ser vistos ni leídos por los proveedores de internet o la compañía que desarrolla esta aplicación y en consecuencia tampoco pueden ser vistos por otros terceros, como gobiernos o criminales.

Esa talanquera matemática que pone la criptografía sobre las conversaciones privadas de las personas es molesta para los gobiernos porque según ellos, entorpece las investigaciones de las autoridades, que no pueden acceder a voluntad a los datos y los mensajes de cualquier persona usuaria de estas aplicaciones. Por esto mismo llevan años impulsando leyes y motivando a las empresas a crear soluciones que les permitan husmear en conversaciones privadas, normalmente, apelando a que sin estas capacidades es muy difícil luchar contra el abuso de menores en internet.

En el pasado, compañías como Facebook y la misma Apple se han opuesto a este tipo de puertas traseras porque temen perder la confianza de quienes usan sus servicios y dispositivos y porque saben que esto pone a muchos de ellos en peligro ya que estos sistemas pueden ser abusados por gobiernos, criminales u otras compañías para espiar conversaciones privadas o acceder a los datos de las personas.

Sin embargo, Apple, aparentemente por su cuenta, ha decidido dar un paso que rompe esta promesa de privacidad y libertad de expresión acogiendo la narrativa de que este tipo de funcionalidades son necesarias en la lucha contra los abusos a menores en internet y simplemente va a poner una puerta trasera que le permite revisar, en este caso todas las imágenes, antes de que salgan del teléfono o después de que sean recibidas. Esta acción rompe la premisa del cifrado de extremo a extremo (E2EE End to End Encryption) que ni las mismas compañías desarrolladoras de estas aplicaciones pueden leer los mensajes que se intercambian en ellas -ver el contenido- y en este mismo sentido rompe la promesa de que los gobiernos o cualquier otro tercero, no pueden meter sus narices en estas conversaciones. Si la empresa puede ver algo, el gobierno o criminales, o la competencia de alguién también.

Aunque Apple alegue que esta ruptura se hace en nombre de la infancia, y que su alcance está delimitado, no puede negar que simplemente introducirá un sistema que rompe con el paradigma del cifrado de extremo a extremo poniendo una puerta trasera que le permite mirar por encima del hombro toda la información que, por el momento, las personas usuarias menores de edad y en Estados Unidos transmiten por iMessage.

Es obvio que estas limitaciones son fácilmente extensibles a otras personas en otras locaciones y para otros tipos de datos.

Pero este es solo uno de los problemas que trae la nueva característica de iMessage. Como ya mencionamos, la identificación de imágenes con contenido sexual se hará con inteligencia artificial, una tecnología propensa a los falsos positivos y engaños. La inteligencia artificial ya se usa para filtrar este contenido que circula en redes sociales. Así por ejemplo, las herramientas de inteligenica artificial que usan Facebook o instagram facilmente confunden una estatua que representa un desnudo, con contenido sexual explícito o fotos de mujeres indígenas con los pechos desnudos, con pornografía pues el sistema no tiene capacidad de discernir el contexto.

Si sumamos a esto que el sistema reporta a los padres y madres del niño o niña si vio o envió contenido sexual por su cuenta de iMessage (incluso si esta persona es advertida de que eso pasará cuando va a ver o enviar una imagen detectada como contenido sexual), estamos hablando de que este niño o niña puede sufrir represalias o ser víctima de abusos por parte de familiares exageradamente estrictos, fanáticos religiosos, homofóbicos, etc. Imagínense la reacción de un papá con valores morales muy conservadores al que le avisan que su hijo de 13 años ha enviado la foto de otro niño desnudo a un grupo de varias personas, ¿su reacción vendrá antes o después de saber que la mamá le pidió que enviara al grupo familiar la foto que acaba de tomar del primito de cuatro años dándose un baño por primera vez en la piscina?

Este sistema, creado con la excusa de proteger los derechos de la infancia en internet, empieza violando su derecho a la intimidad y la privacidad delegando su supervisión a una inteligencia artificial. No es difícil imaginar lo que puede pasar con este sistema a una escala mayor. Por ejemplo, si ya no es contenido sexual explícito en teléfonos en manos de niños, niñas y adolescentes, sino filtraciones sobre corrupción del gobierno de turno, y ya no solo son los menores de edad sino la ciudadanía de un país, y si la queja no va al papá o la mamá, sino a las autoridades.

Pero esto no es todo, los cambios en iCloud que van por la misma línea son realmente preocupantes también.

De ahora en adelante, todas las imágenes en iCloud Photos serán escaneadas automáticamente antes de ser subidas a la nube para obtener un hash, una especie de identificador que se calcula con los datos que componen un archivo, para compararlo con una tabla de hashes que coinciden con imágenes catalogadas como CSAM (Child Sexual Abuse Material o Material de Abuso Sexual a Menores, en español). Esta tabla es proveída por el Centro Nacional Para Los Niños Perdidos y Explotados (National Center for Missing and Exploited Children, NCMEC) y otras organizaciones de este tipo. Si el sistema de comparación de hashes encuentra varias coincidencias entre los archivos de una persona y los hashes catalogados como CSAM, Apple confirma manualmente y procede a reportar a la persona usuaria al mismo NCMEC y a suspender su cuenta, con derecho a apelación. Igual que con el sistema de iMessage, esta revisión funciona del lado del cliente (client-side) y está impulsada con inteligencia artificial.

E igualmente, aunque Apple, se autolimite sobre el contenido que está buscando y diga que al funcionar en el equipo del cliente y no en sus servidores preserva la privacidad, sigue siendo una puerta trasera por la que Apple puede husmear en todos los contenidos del dispositivo con las mismas potenciales extrapolaciones que puede hacer con el sistema de iMessage.

https://twitter.com/Snowden/status/1423469854347169798)

<Advertencia: párrafo aburrido y técnico, si quiere, no lo lea>

Es importante señalar que los hashes usados en esta nueva característica no son los comunes que conocemos criptográficamente, donde un hash solo puede representar un archivo, y cualquier cambio, así sea de un bit en dicho archivo cambiaría por completo el hash que lo representa. En este caso estamos hablando de hashes neuronales (por aquello de las redes neuronales del machine learning y la inteligencia artificial). Estos hashes no coinciden con un solo archivo sino que identifican la misma imagen así esta haya sido modificada, es decir, diferentes imágenes derivadas de una misma fuente original pueden compartir el mismo hash neuronal.

<fin del párrafo aburrido/>.

En palabras mucho más simples: el sistema consiste en una inteligencia artificial que puede identificar imágenes derivadas de otras, para este caso, imágenes de las bases de datos de CSAM de entidades como NCMEC.

Como en el caso de iMessage, estas inteligencias artificiales son propensas al error con el agravante de que existen técnicas documentadas para engañarlas, que ponen en duda la efectividad del sistema, su resistencia al abuso y su viabilidad a largo plazo.

Las bases de datos también son un problema porque son manipulables, y un actor malicioso (lo que puede incluir a algún Estado) podría introducir registros que se acomoden a sus intereses en búsqueda de opositores, activistas, periodistas y un largo etcétera.

Múltiples organizaciones se han pronunciado hace mucho tiempo sobre la importancia de mantener estándares criptográficos fuertes para defender la privacidad, la libertad de expresión y otros derechos humanos que pueden verse gravemente afectados con la degradación de las plataformas de comunicaciones seguras. Sí, las pretensiones de los gobiernos de tener acceso a las comunicaciones privadas de las personas buscan debilitar los sistemas criptográficos, lo raro de este caso es que Apple se está adelantando a las presiones oficiales y lo haga por su cuenta.

Crypto Wars, las guerras contra la criptografía es como se conoce a una sucesión de hechos que históricamente han intentado alejar la criptografía de las personas y dejar su exclusividad de uso en manos del gobierno, sin embargo, gracias al movimiento de código abierto, Open Source, es posible tener esta poderosa herramienta matemática que garantiza derechos, en manos de la gente. La lucha en contra de los crímenes contra la infancia merece la atención y la cooperación de todas las personas, pero esta no se ataca sustancialmente encontrando las imágenes sino disminuyendo la impunidad y aumentando los recursos de las autoridades para encontrar a las personas que hacen daño a niños, niñas y adolescentes, de lo contrario nos pasaremos buscando contenido que seguirá circulando y en nombre de esa pesca de imágenes se generará una grave afectación a los derechos de las personas.

Esta nueva batalla de las guerras contra la criptografía, es un ataque desde la empresa privada y no desde un gobierno como venía sucediendo hasta ahora. Las alarmas ya están prendidas y la resistencia la seguiremos haciendo desde los grupos que entendemos y abogamos por la importancia de la criptografía para el ejercicio de derechos.

Actualización 09/09/2021

El 3 de septiembre de 2021, la compañía Apple anunció en su página de Child Safety que aplazaba el lanzamiento de las características mencionadas en este texto, basada en la retroalimentación recibida por parte de clientes, grupos de activistas, investigadores y otros. Solo mientras recibe más aportes y hace mejoras antes de implementar el sistema oficialmente.